Nie masz produktów w koszyku.

Historia rozwoju personalnych komputerów

2017-08-14 11:56:26

W tym artykule opisano główne etapy rozwoju komputerów. Podstawowe kierunki rozwoju technologii informatycznych oraz przyczyny tego rozwoju.

W tym artykule opisano główne etapy rozwoju komputerów. Podstawowe kierunki rozwoju technologii informatycznych oraz przyczyny tego rozwoju.

Główne etapy rozwoju komputerów:

W trakcie ewolucji technologii komputerowych zostały opracowane setki różnych komputerów. Wielu z nich dawno zapomniane, podczas gdy wpływ innych na nowoczesne pomysły okazały się bardzo istotne. W niniejszym artykule otrzymasz krótki przegląd niektórych kluczowych momentów historycznych, w celu lepszego zrozumienia, w jaki sposób developerzy przychodzą do koncepcji nowoczesnych komputerów. Rozpatrzymy tylko główne punkty rozwoju, pozostawiając wiele szczegółów „za nawiasami”. Komputery, które weźmiemy pod uwagę przedstawione w tabeli poniższej.

Główne etapy historii komputerów:

|

Rok Produkcji |

Nazwa Komputera |

Twórca |

Uwagi |

|

1834 |

Maszyna analityczna |

Charles Babbage |

Pierwsza próba zbudowania komputera cyfrowego |

|

1936 |

Z1 |

Konrad Tsuze |

Pierwszy przekaźnikowy komputer |

|

1943 |

„COLOSSUS” |

Rząd brytyjski |

Pierwszy komputer elektroniczny |

|

1944 |

Mark I |

Howard Aiken |

Pierwszy amerykański wielofunkcyjny komputer |

|

1946 |

ENIAC I |

John Eckert Jr./John Mauchly |

Dzięki tej maszynie zaczyna się historia nowoczesnych komputerów |

|

1949 |

EDSAC |

Maurice Wilkes |

Pierwszy komputer z programami przechowywanymi w pamięci |

|

1951 |

Whirlwind I |

MIT |

Pierwszy komputer w czasie rzeczywistym |

|

1952 |

IAS |

Von Neumann |

Ten projekt jest używany w większości nowoczesnych komputerach |

|

1960 |

PDP-1 |

DEC |

Pierwszy mini-komputer (sprzedane 50 egzemplarzy) |

|

1961 |

1401 |

IBM |

Bardzo popularny mały komputer |

|

1962 |

7094 |

IBM |

Bardzo popularna mała maszyna obliczeniowa |

|

1963 |

В5000 |

Burroughs |

Pierwsza maszyna, zaprojektowana dla języka wysokiego poziomu |

|

1964 |

360 |

IBM |

Pierwsza rodzina komputerów |

|

1964 |

6600 |

CDC |

Pierwszy superkomputer do obliczeń naukowych |

|

1965 |

PDP-8 |

DEC |

Pierwszy mini-komputer masowej konsumpcji (sprzedano 50 000 egzemplarzy) |

|

1970 |

PDP-11 |

DEC |

Te mini-komputery dominowały na rynku komputerowym w latach 70-tych |

|

1974 |

8080 |

Intel |

Pierwszy uniwersalny 8-bitowy komputer na chipie |

|

1974 |

CRAY-1 |

Cray |

Pierwszy wektorowy superkomputer |

|

1978 |

VAX |

DEC |

Pierwszy 32-bitowy super minikomputer |

|

1981 |

IBM PC |

IBM |

Nadchodzi era współczesnych komputerów osobistych |

|

1981 |

Osbome-1 |

Osborne |

Pierwszy komputer przenośny |

|

1983 |

Lisa |

Apple |

Pierwszy komputer z graficznym interfejsem użytkownika |

|

1985 |

386 |

Intel |

Pierwszy 32-bitowy poprzednik serii Pentium |

|

1985 |

MIPS |

MIPS |

Pierwszy komputer RISC |

|

1987 |

SPARC |

Sun |

Pierwsza stacja robocza RISC na bazie procesora SPARC |

|

1990 |

RS6000 |

IBM |

Pierwszy superskalarny komputer |

|

1992 |

Alpha |

DEC |

Pierwszy 64-bitowy komputer |

|

1993 |

Newton |

Apple |

Pierwszy „kieszonkowy” komputer |

Z historii można wyróżnić 6 etapów rozwoju komputerów: pokolenie mechanicznych komputerów, komputery na lampach elektronowych (takie jak ENIAC), komputery tranzystorowe (IBM 7094), pierwsze komputery oparte na układach scalonych (IBM 360), komputery osobiste (linia z CPU Intel) i tak zwane komputery „niewidoczne”.

Komputery zerowej generacji — mechaniczne komputery (1642-1945)

Pierwszą osobą, która stworzyła maszynę liczenia, był francuski uczony Blaise Pascal (1623-1662), na cześć którego nazwano jeden z języków programowania. Pascal skonstruował maszynę w 1642 roku, gdy miał zaledwie 19 lat, dla swojego ojca, poborcy skarbowego. To była konstrukcja mechaniczna z biegów i napędem ręcznym. Licząca maszyna Pascala mogła wykonać tylko operacje dodawania i odejmowania.

Pierwszą osobą, która stworzyła maszynę liczenia, był francuski uczony Blaise Pascal (1623-1662), na cześć którego nazwano jeden z języków programowania. Pascal skonstruował maszynę w 1642 roku, gdy miał zaledwie 19 lat, dla swojego ojca, poborcy skarbowego. To była konstrukcja mechaniczna z biegów i napędem ręcznym. Licząca maszyna Pascala mogła wykonać tylko operacje dodawania i odejmowania.

Trzydzieści lat później, wielki matematyk niemiecki Gotfrid Vilgelm Leybnits (1646-1716) zbudował inną maszynę mechaniczną, która oprócz dodawania i odejmowania mogła wykonać operację mnożenia i dzielenia. W rzeczywistości, Leibniz trzy wieki temu stworzył namiastkę kalkulatora z czterema funkcjami.

Jeszcze przez 150 lat, profesor matematyki Uniwersytetu w Cambridge, Charles Babbage (1792-1871), wynalazca prędkościomierza, On opracował i zaprojektował maszynę różnicącą. Ta mechaniczna maszyna, która podobnie jak maszyna Pascala może tylko dodawać i odejmować, liczyła tabeli liczb do nawigacji morskiej. Maszyna została wyposażona tylko w jeden algorytm — metoda różnic skończonych przy użyciu wielomianów. Maszyna miała dość zabawny sposób wyświetlania informacji: wyniki wyciskali się stalową pieczęcią na płytce miedzianej, co przewidowało nowsze narzędzia we/wy — karty dziurkowane i płyty cd.

Mimo, że jego urządzenie działało całkiem nieźle, Bebbig`a wkrótce znudziła maszyna, wykonująca tylko jeden algorytm. On Spędził bardzo dużo czasu, większość swojego rodzinnego stanu i jeszcze 17 000 funtów, przyznanych przez rząd, na tworzenie maszyny analitycznej. U analitycznej maszyny było 4 składnika: urządzenie pamięci (pamięć), urządzenie obliczania, urządzenie wejściowe (do odczytu kart perforowanych), urządzenie wyjściowe (młotek i urządzenie drukujące). Pamięć składała się z 1000 słów na 50 miejsc dziesiętnych; każde ze słów zawierało zmienne i wyniki. Urządzenie obliczeniowe odbierało operandy z pamięci, następnie wykonywało operację dodawania, odejmowania, mnożenia lub dzielenia i zwracało wynik z powrotem do pamięci. Jak i maszyna różnicowa, urządzenie to było mechaniczne.

Zaletą maszyny analitycznej było to, że ona mogła wykonywać różne zadania. Urządzenie czytało komendy z kart dziurkowanych i wykonywało je. Niektóre polecenia kazali urządzeniu wziąć 2 numery z pamięci, przenieść je do urządzenia liczącego, wykonać operacji na nim (na przykład, dodawanie) i wysłać wynik z powrotem do pamięci. Inne komendy sprawdzali liczbe, a czasami popełniali operację przejścia w zależności od tego, cz to dodatnie lub ujemne. Przy podawaniu dziurkowanego czytnika kart z innym programem, to urządzenie wykonuje inny zestaw działań. Oznacza to że w przeciwieństwie do różnicy analityczna Maszyna może wykonywać kilka algorytmów.

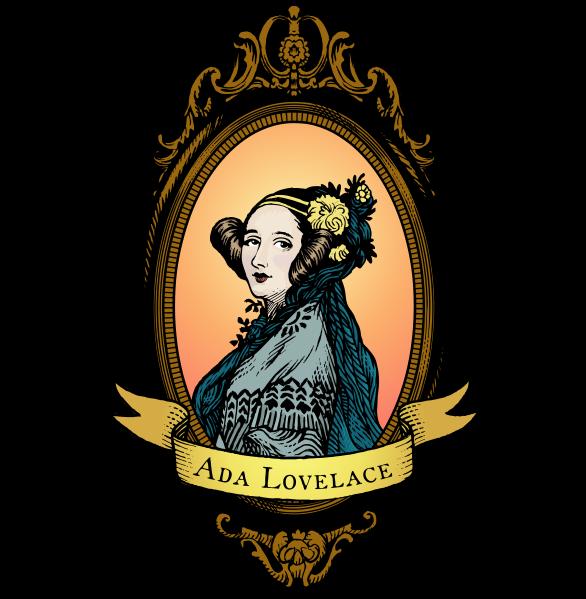

Ponieważ maszyna analityczna została zaprogramowana na podstawowym asemblerze, jej było potrzebne oprogramowanie. Do tworzenia oprogramowania, Babbage zatrudnił młodą kobietę — Ada Augusta Lovelace, córka słynnego brytyjskiego poety Lorda Byrona. Ada Lovelace była pierwszym na świecie programistą. Na jej cześć nazwano nowoczesny język programowania — Ada.

Ponieważ maszyna analityczna została zaprogramowana na podstawowym asemblerze, jej było potrzebne oprogramowanie. Do tworzenia oprogramowania, Babbage zatrudnił młodą kobietę — Ada Augusta Lovelace, córka słynnego brytyjskiego poety Lorda Byrona. Ada Lovelace była pierwszym na świecie programistą. Na jej cześć nazwano nowoczesny język programowania — Ada.

Niestety, jak wiele nowoczesnych inżynierów, Babbage nigdy nie debugował komputera. On potrzebował tysiące biegów, wykonane z taką precyzją, która w XIX wieku była niedostępna. Ale pomysły Babbage'a wyprzedzały swoje czasy, i nawet dzisiaj najnowocześniejsze komputery w konstrukcji podobny do jego maszyny analitycznej. Dlatego można śmiało powiedzieć, że Babbage był dziadkiem współczesnego komputera cyfrowego.

Pod koniec lat 30-tych Niemiec Konrad Zus (Konrad Zuse) skonstruował kilka automatów liczenia za pomocą przekaźników elektromagnetycznych. Nie udało mu się zdobyć pieniądze od rządu do jego rozwoju, bo zaczęła się wojna. Zus nic nie wiedział o pracy Babbage'a, jego maszyny zostały zniszczone podczas bombardowania Berlina w 1944 roku, dlatego jego praca nie miała wpływu na przyszły rozwój technologii komputerowej. Jednak, był jednym z pierwszych w tej dziedzinie.

Nieco później, maszyny liczące zostały zaprojektowane w Ameryce. Maszyna Johna Atanasowa (John Atanasoff) była bardzo zaawansowana jak na swoje czasy. W niej użyto binarnej arytmetykę i informacyjne pojemności, które były okresowo aktualizowane, aby uniknąć niszczenia danych. Nowoczesna pamięć dynamiczna (RAM) działa na dokładnie tej samej zasadzie. Niestety, ta maszyna nie stała się aktywną. W pewnym sensie Atanasow był podobny do Babbage`a — marzycielem, który nie był zadowolony z technologią swoich czasów.

Komputer George`a Stibitsa (George Stibbitz) naprawdę działał, chociaż był bardziej prymitywny, niż maszyna Atanasowa. Stibits pokazał swoją maszynę na konferencji w Dartmouth College w 1940 roku. Na tej konferencji był John Mouchli (John Mauchley), zwykły w tym momencie profesor fizyki z uniwersytetu w Pensylwanii. Później stał się bardzo znany w dziedzinie komputerowego rozwoju.

Dopóki Zus, Stibits i Atanasow opracowywały automatyczne obliczane maszyny, młody Howard Aiken (Howard Aiken) w Harwardzie uparcie projektował ręczne maszyny liczące w ramach pracy doktorskiej. Po zakończeniu badania Aiken zrozumiał znaczenie automatycznych obliczeń. On poszedł do biblioteki, przeczytał pracę Babbage i postanowił stworzyć z przekaźników taki samy komputer, który dla Babbage`a nie udało się stworzyć z kół zębatych.

Praca nad pierwszym komputerem Aikena «Mark I» została zakończona w 1944 roku. Komputer miał 72 słowa na 23 miejsca dziesiętne każdy i mógł wykonać dowolne polecenie w ciągu 6 sekund. W urządzeniu wejścia-wyjścia były wykorzystywane taśmy perforowane. Do tego czasu, jak Aiken ukończył pracę nad komputerem «Mark II», przekaźnikowe komputery były już nieaktualne. Rozpoczęła się era elektroniki.

Pierwsza generacja — lampy elektronowe (1945-1955)

Bodźcem do stworzenia elektronicznego komputera stała się Druga Wojna Światowa. Na początku wojny niemieckie okręty podwodne zniszczały brytyjskie wojskowe statki. Niemieckie admirały przesyłali do okrętów podwodnych rzędy przez radio, i choć Brytyjczycy byli w stanie przechwycić te polecenia, problem był w tym, że radiogramy zostały zakodowane za pomocą urządzenia o nazwie ENIGMA, poprzednikem którego został zaprojektowany przez wynalazcę, amatora i byłego prezydenta USA Thomasa Jeffersona.

Na początku wojny Brytyjczykam udało się zdobyć Enigmę u Polaków, które z kolei ukradli go od Niemców. Jednak, żeby rozszyfrować zakodowaną wiadomość, to potrzebował ogromnej ilości obliczeń, którę musiały być wykonane natychmiast po przejęciu radiogramów. W związku z tym, rząd brytyjski utworzył tajny laboratorium do stworzenia komputera elektronicznego o nazwie COLOSSUS. W tworzeniu tej maszyny brał udział słynny brytyjski matematyk Alan Turing. COLOSSUS zaczął działac już w 1943 roku, ale, tak jak brytyjski rząd w pełni kontrolował ten projekt i badał ją jak tajemnicę wojskową na przestrzeni 30 lat, COLOSSUS nie stał się bazą dla dalszego rozwoju komputerów. Wspomnieliśmy o nim tylko dlatego, że był to pierwszy na świecie elektroniczny komputer cyfrowy.

Druga Wojna Światowa wpłynęła na rozwój techniki komputerowej i w USA. Armii potrzebne były tabele, które zostały użyte w ukierunkowaniu ciężkiej artylerii. Setki kobiet byli zatrudnieni do obliczeń na ręcznych maszynach do liczenia i wypełnienie pola tabel (było uważano, że kobiety ostrożniej w obliczeniach, niż mężczyźni). Jednak proces ten wymagał wiele czasu i często zdarzały się błędy.

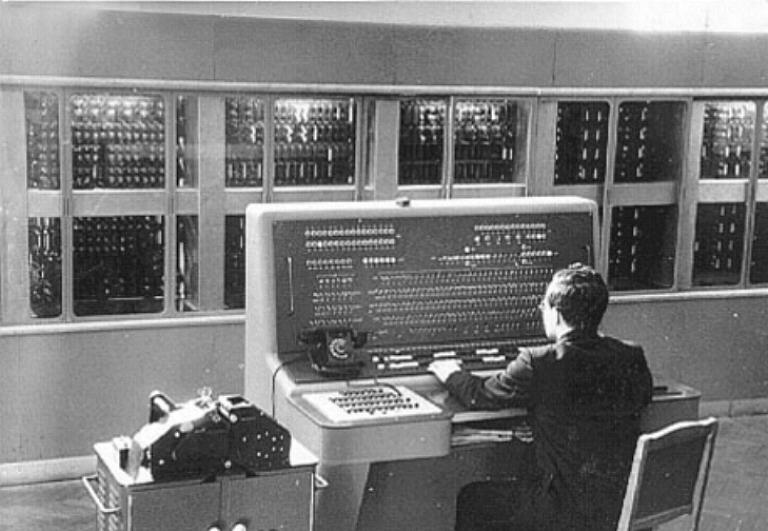

John Mouchli, który został zaznajomiony z pracami Antonosowa i Stibitsa, wiedział, że armia jest zainteresowana rachunkowych maszynach. On zażądał od armii finansowania prac nad tworzeniem elektronicznego komputera. Wymaganie było spełnione w 1943 roku, i Mouchli ze swoim studentem J. Presperom Eckert`em (J. Presper Eckert) zaczęli projektować elektroniczny komputer, który oni nazwali ENIAC (Electronic Numerical Integrator and Computer — elektroniczny cyfrowy integrator i kalkulator). ENIAC Składał się on z 18.000 lamp próżniowych i 1500 przekaźników, ważył 30 ton i pochłonął 140 kilowatów energii elektrycznej. Maszyna miała 20 rejestrów, z których każdy może zawierać 10-bitową liczbę dziesiętną. (Dziesiętny rejestr — pamięć bardzo małej ilości, który może pomieścić wiele do konkretnego maksymalnej liczby bitów, coś w rodzaju licznika, który zapisuje przebieg przebytej drogi samochodem.) W ENIAC było ustawiono 6000 wielokanałowych przełączników i mnóstwo kabli, podłączonych do złączy.

John Mouchli, który został zaznajomiony z pracami Antonosowa i Stibitsa, wiedział, że armia jest zainteresowana rachunkowych maszynach. On zażądał od armii finansowania prac nad tworzeniem elektronicznego komputera. Wymaganie było spełnione w 1943 roku, i Mouchli ze swoim studentem J. Presperom Eckert`em (J. Presper Eckert) zaczęli projektować elektroniczny komputer, który oni nazwali ENIAC (Electronic Numerical Integrator and Computer — elektroniczny cyfrowy integrator i kalkulator). ENIAC Składał się on z 18.000 lamp próżniowych i 1500 przekaźników, ważył 30 ton i pochłonął 140 kilowatów energii elektrycznej. Maszyna miała 20 rejestrów, z których każdy może zawierać 10-bitową liczbę dziesiętną. (Dziesiętny rejestr — pamięć bardzo małej ilości, który może pomieścić wiele do konkretnego maksymalnej liczby bitów, coś w rodzaju licznika, który zapisuje przebieg przebytej drogi samochodem.) W ENIAC było ustawiono 6000 wielokanałowych przełączników i mnóstwo kabli, podłączonych do złączy.

Praca nad maszyną została zakończona w 1946 roku, kiedy była już nie potrzebna — przynajmniej dla osiągnięcia pierwotnie założonych celów.

Ponieważ wojna się skończyła, Mouchli i Eckertu pozwoliły zorganizować szkołę, gdzie one mówili o swojej pracy kolegom naukowcom. W tej szkole i narodził się interes do tworzenia dużych komputerów cyfrowych.

Po pojawieniu szkoły za konstruowanie elektronicznych maszyn liczących się wzięli inni badacze. Pierwszy komputer roboczy był EDSAC (1949 rok). Ta maszyna stworzona przez Maurica Wilkesa w Uniwersytecie w Cambridge. Dalej — Johniac w korporacji Rand, ILLIAC w Uniwersytecie Illinois, MANIAC w laboratorium Los Alamos oraz WEIZAC w Instytucie Weizmanna w Izraelu.

Eckert i Moushli wkrótce zaczęli pracę nad maszyną EDVAC (Electronic Discrete Variable Computer —elektroniczna dyskretna parametryczna maszyna). Niestety, ten projekt zamknął się, gdy odeszli z uczelni, aby założyć komputerową korporacje w Filadelfii (Silicon Valley tedy jeszcze nie było). Po serii fuzji, spółka stała się nazywać Unisys Corporation.

Eckert i Moushli chcieli uzyskać patent na wynalazek cyfrowej obliczeniowej maszyny. Po kilku latach pozwu wydano decyzję że patent jest nieważny, ponieważ komputer cyfrowy wymyślił Atanasow, choć on ją nie opatentował.

Podczas gdy Eckert i Moushli pracowali nad maszyną EDVAC, jeden z uczestników projektu ENIAC, John Von Neiman, pojechał do Instytutu badań specjalnych w Princeton, aby stworzyć własną wersję EDVAC pod nazwą IAS (Immediate Address Storage — pamięć z adresowaniem bezpośrednim). Von Neiman był geniuszem w tych samych obszarach, co i Leonardo da Vinci. Znał wiele języków, był specjalistą w dziedzinie fizyki i matematyki, posiadał fenomenalną pamięć: on pamiętał wszystko, co kiedykolwiek słyszał, widział lub czytał. Mógł dosłownie zacytować z pamięci tekst książek, które czytał kilka lat temu. Gdy Von Neumann zainteresował się komputerami, był już najbardziej znanym matematykiem na świecie.

Von Neumann został szybko zorientowany, że tworzenie komputerów z dużej liczby przełączników i kabli wymaga dużo czasu i jest bardzo uciążliwe. Przyszedł do przekonania, że program powinien być reprezentowany w pamięci komputera w postaci cyfrowej, wraz z danymi. On również zaznaczył, że arytmetyka dziesiętna, używana w maszynie ENIAC, gdzie każda cyfra była reprezentowana przez dziesięć lamp próżniowych A jest włączany i wyłączany 9), powinna być zastąpiona równoległej binarną arytmetyką. Między innymi Atanasow przyszedł do podobnego pomysłu dopiero po kilku latach.

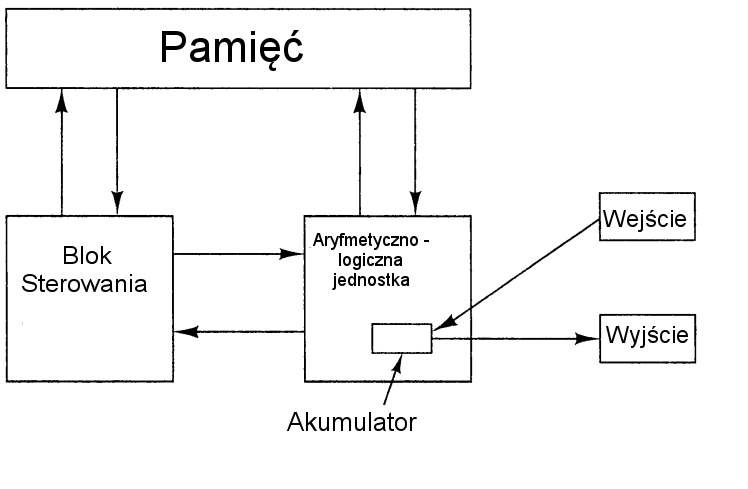

Główny projekt, który Von Neumann opisał na początku, znany teraz jako maszyna obliczeniowa von Neumanna. On został stosowany w EDSAC, pierwszej maszynie z programą w pamięci, i nawet teraz, ponad pół wieku później, jest podstawą większości współczesnych komputerów cyfrowych. Sama idea i maszyna IAS mieli bardzo duży wpływ na dalszy rozwój technologii komputerowej, dlatego warto krótko opisać projekt von Neumanna. Warto mieć na uwadze, że choć projekt i jest związana z nazwą von Neumanna, w jego tworzeniu wzięli czynny udział inni naukowcy — w szczególności, Goldstein.Architektury maszyny pokazano na rysunku poniżej:

Schemat obliczeniowej maszyny von Neumanna.

Maszyna von Neumanna składała się z pięciu głównych części: pamięci, jednostka arytmetyczno-logiczna, jednostka sterująca i urządzenia wejścia-wyjścia. Pamięć zawiera 4096 słów o 40 bitów, bit jest 0 lub 1. Każde słowo zawierało lub 2 komendy po 20 bitów, lub liczbe całkowitą ze znakiem na 40 bitów. 8 bitów wskazywały na rodzaj polecenia, a pozostałe 12 bitów utożsamiali jeden z 4096 słów. Jednostka arytmetyczna i jednostka sterująca to "centrum dowodzenia" komputera. W nowoczesnych maszynach te bloki są połączone w jednym układzie nazywają się jednostką centralną (CPU).

Wewnątrz jednostki logicznej arytmetyki został specjalny rejestr wewnętrznych o 40-bitowe, tak zwany akumulator. Przykładowa komenda dodawała słowo z pamięci w akumulatorze lub zachowywała zawartość akumulatora w pamięci. Ta maszyna nie wykonywała operacje arytmetyczne z liczb zmiennoprzecinkowych, ponieważ Von Neumann uważał, że każdy właściwy matematyk jest w stanie utrzymać liczby zmiennoprzecinkowe w głowie.

W tym samym czasie, gdy Von Neumann pracował nad swają maszyną IAS, naukowcy z MIT opracowywały swój komputer Whirlwind I. W przeciwieństwie do IAS, ENIAC i innych maszyn tego samego typu ze słowami dużej długości, maszyna Whirlwind I miała 16-bitowe słowa, i przeznaczona do pracy w czasie rzeczywistym. Ten projekt doprowadził do wynalezienia Jay`jem Forresterem (Jay Forrester) pamięci na rdzeniu magnetycznym, a następnie pierwszego seryjnego mini-komputera.

W tym czasie IBM była małą firmą, która produkowała karty dziurkowane i mechaniczne urządzenia do sortowania kart dziurkowanych. Chociaż firma IBM częściowo sfinansowała projekt Aikena, ona nie była zainteresowana w komputerach, i dopiero w 1953 roku zbudowała komputer 701, przez wiele lat po tym, jak firma Eckert i Moushli z komputerem UNIVAC stała numerem jeden na rynku komputerów.

W 701 było 2048 słów na 36 bitów, każde słowo zawierało dwa polecenia. 701 stał się pierwszym komputerem, wiodącym na rynku w ciągu dziesięciu lat. Trzy lata później pojawił się komputer 704, który miał 4 KB pamięci na rdzeni magnetycznej, komendy po 36 bit i procesor zmiennoprzecinkowych. W 1958 roku firma IBM rozpoczęła pracę nad najnowszym komputerem na lampach elektronowych, 709, który w rzeczywistości stanowił znacznie bardziej skomplikowaną wersję 704.

Druga generacja — tranzystory (1955-1965)

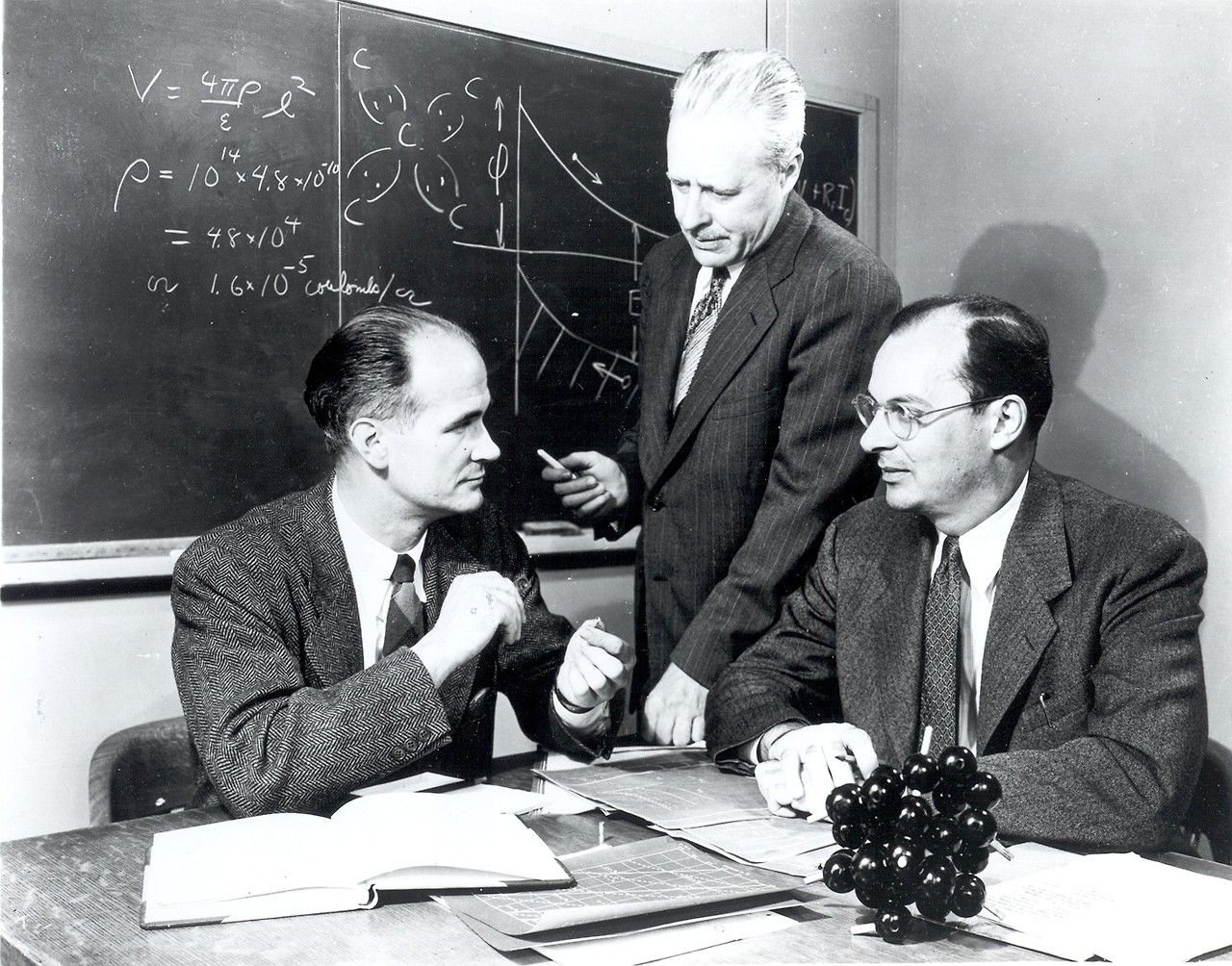

Tranzystor został wymyślony przez pracowników laboratorium Bell Laboratories Johnem Bardeen`em (John Bardeen), Walter`em Brattain`em (Walter Brattain) i William`em Shockley`jem (William Shockley), dla których w 1956 roku zostały przyznane nagrody Nobla w dziedzinie fizyki. Przez dziesięć lat, tranzystory zrewolucjonizowały produkcję komputerów, i do końca lat 50-tych komputery na lampach próżniowych już beznadziejnie przestarzałe. Pierwszy komputer tranzystorowy został zbudowany w MIT (Massachusetts Institute Laboratorium Techniczne). Zawierał słowa 16-bitowe, jak i Whirlwind I. Komputer nazywał się ТХ-0 (Transistorized experimental computer 0 — eksperymentalna tranzysterowa obliczeniowa maszyna 0) i był przeznaczony tylko do testów przyszłej maszyny ТХ-2.

Tranzystor został wymyślony przez pracowników laboratorium Bell Laboratories Johnem Bardeen`em (John Bardeen), Walter`em Brattain`em (Walter Brattain) i William`em Shockley`jem (William Shockley), dla których w 1956 roku zostały przyznane nagrody Nobla w dziedzinie fizyki. Przez dziesięć lat, tranzystory zrewolucjonizowały produkcję komputerów, i do końca lat 50-tych komputery na lampach próżniowych już beznadziejnie przestarzałe. Pierwszy komputer tranzystorowy został zbudowany w MIT (Massachusetts Institute Laboratorium Techniczne). Zawierał słowa 16-bitowe, jak i Whirlwind I. Komputer nazywał się ТХ-0 (Transistorized experimental computer 0 — eksperymentalna tranzysterowa obliczeniowa maszyna 0) i był przeznaczony tylko do testów przyszłej maszyny ТХ-2.

Urządzenie MX-2 nie miała wielkiego znaczenia, ale jeden z inżynierów laboratorium, Kenneth Olsen (Kenneth Olsen), w 1957 roku założył firmę DEC (Digital Equipment Corporation — firma w produkcji urządzeń cyfrowych), w celu wytworzenia urządzenia do produkcji, podobną do TX-0. Ta maszyna, PDP-1, pojawiła się tylko przez cztery lata, głównie dlatego, że ci, którzy finansowali DEC, uważali nieopłacalną produkcja komputerów. Dlatego firma DEC sprzedawała głównie małe elektroniczne karty.

Komputer PDP-1 pojawił się dopiero w 1961 roku. On miał 4096 słów 18 bitów i prędkości 200 000 komendy na sekundę.

Parametr ten był w połowie mniej, niż w 7090, odpowiednika tranzystorowego 709. PDP-1 był najszybszy komputer na świecie w tym czasie. PDP-1 kosztował 120 000 dolarów, podczas gdy 7090 kosztował miliony. Firma DEC sprzedała kilkadziesiąt komputerów PDP-1, i tak pojawił się przemysł komputerowy.

Jedną z pierwszych maszyn modelu PDP-1 oddali w MIT, gdzie ona od razu przyciągnęła uwagę niektórych młodych naukowców, doprowadzających wielkie nadzieje. Jedną z innowacji PDP-1 został w wyświetlacz o wielkości 512 x 512 pikseli, na którym można było rysować punkty. Wkrótce studenci MIT wykonały specjalny program dla PDP-1, do gry w "Wojnę światów" — pierwszą na świecie grę komputerową.

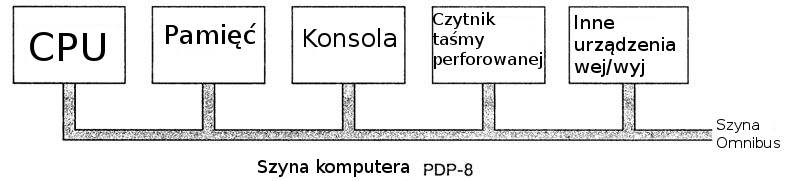

Przez kilka lat firma DEC opracowała model PDP-8, 12-bitowy komputer. PDP-8 kosztował dużo taniej, niż PDP-1 (6 000 dolarów). Główną innowacją jest jedyny pass (omnibus), jak przedstawiono na rysunku poniżej.

Szyna komputera PDP-8.

Szyna — to zestaw połączonych równolegle przewodów do połączenia składników komputera. Ta innowacja radykalnie odróżnia PDP-8 od IAS. Taka struktura od tego czasu stała stosowana we wszystkich komputerach. Firma DEC sprzedała 50 000 komputerów modelu PDP-8 i stała się liderem na rynku mini-komputerów.

Jak już wspomniano, wraz z wynalezieniem tranzystorów firma IBM stworzyła tranzystorową wersję 709 — 7090, a później — 7094. W tej wersji, czas cyklu wynosił 2 mikrosekundy, i pamięć składała się z 32,536 słów po 36 bitów. 7090 i 7094 były ostatnymi komputerami typu ENIAC, ale one są powszechnie używane do obliczeń naukowych w latach 60-tych ubiegłego wieku.

Firma IBM wyprodukowała również komputery 1401 do rozliczeń handlowych. Maszyna ta mogła odczytywać i zapisywać taśmy magnetyczne i karty dziurkowane i wydrukować wynik tak szybko, jak 7094, ale kosztowała taniej. Ten model nie nadaje się do obliczeń naukowych, ale to było bardzo wygodne dla prowadzenia ewidencji gospodarczej.

U 1401 nie było registrów i stałej długości słowa. Pamięć zawierał 4000 bajtów na 8 bitów (w nowszych modelach objętość wzrosła do niewyobrażalnych w tym czasie 16 000 bajtów). Każdy bajt zawiera symbol w 6 bitów, administracyjny bit oraz bit do wskazania końca słowa. Komand MOVE, na przykład, posiada adres źródłowy i adres docelowy. Polecenie to przesuwa bajty z pierwszego adresu w drugi, aż bit końca słowa nie przyjmie wartość 1.

W 1964 roku firma CDC (Control Data Corporation) wydała maszynę 6600, która pracowała prawie znacznie szybciej, niż 7094. Ten komputer do skomplikowanych obliczeń cieszył się dużą popularnością, a firma CDC poszła "w górę". Sekret tak wysokiej wydajności polegała na tym, że wewnątrz procesora (CPU) znajdowała się maszyna z wysokim stopniem równoległości. Maszyna miała kilka funkcjonalnych urządzeń do dodawania, mnożenia i dzielenia którę mogli pracować jednocześnie. Aby maszyna szybko działała, trzeba było zrobić dobry program, a dołączając niektóre wysiłki, można było zrobić tak, aby maszyna wykonała 10 poleceń jednocześnie.

Wewnątrz maszyny 6600 było wbudowane kilka małych komputerów. Więc procesor wytwarzał tylko liczenie liczb a inne funkcje (kontrola funkcjonowania urządzenia, jak również dane wejściowe i wyjściowe) wykonywali małe komputery. Niektóre zasady pracy urządzenia 6600 są używane i w nowoczesnych komputerach.

Projektant komputera Seymur Krey 6600 (Seymour Cray) był postacią legendarną, jak i Von Neumann. Poświęcił swoje życie do stworzenia bardzo wydajnych komputerów, które nazywają się teraz superkomputery. Wśród nich można nazwać 6600, 7600 i Сгау-1. Seymur Krey również jest autorem słynnego "algorytmu zakupu samochodów": idziesz do sklepu najbliżej twojego domu, pokazujesz na samochód najbliżej do drzwi, i mówisz: «Biorę ten». Ten algorytm pozwala poświęcić minimum czasu na nie ważne sprawy (zakup samochodów) i pozwala na większą część czasu na ważne (opracowanie superkomputerów).

Warto wspomnieć jeszcze jeden komputer — Burroughs B5000. Twórcy maszyny PDP-1, 7094 i 6600 zajmowali się tylko sprzętem, starając się obniżyć jego cenę (DEC) lub zmusić pracować szybciej (IBM i CDC). Oprogramowanie nie zmieniało się. Producenci В5000 poszedli inną drogą. Oni opracowali maszynę z zamiarem zaprogramować ją na języku Algol 60 (poprzednik języków С oraz Java), skonstruować sprzęt tak, aby uprościć zadanie kompilatora. Tak pojawił się pomysł, że przy opracowywaniu komputera trzeba również wziąć pod uwagę i oprogramowanie. Ale wkrótce pomysł ten został zapomniany.

Trzecia generacja — układy scalone (1965-1980)

Wynalazek w 1958 roku Robertem Nojsem (Robert Noyce) krzemowego układu scalonego oznaczało możliwość umieszczenia na jednym małym chipie kilkunastu tranzystorów. Komputery na zintegrowanych układach były mniejsze, działały szybciej i były tańsze, niż ich poprzednicy na tranzystorach.

Do 1964 roku firma IBM była liderem na rynku komputerów, ale był jeden wielki problem: komputery 7094 i 1401, które ona produkowała, Nie były między sobą kompatybilne. Jeden z nich był przeznaczony dla skomplikowanych obliczeń, w nim była użyta arytmetyka binarna na rejestrach na 36 bit, w drugim stosowano dziesiętny system liczbowy i słowa o różnej długości. Wielu klientów posiadali obu tych komputerów, i dla nich nie podobało się że urządzenia absolutnie nie kompatybilne między sabą.

Kiedy nadszedł czas, aby wymienić te dwie serie komputerów, firma IBM zrobiła zdecydowany krok. Ona wydała linię tranzystorowych komputerów System/360, które były przeznaczone zarówno dla badań naukowych, jak i do rozliczeń handlowych. Linia System/360 miała wiele innowacji. To była cała rodzina komputerów do pracy z jednym językiem (assemblerem). Każdy nowy model miał więcej możliwości niż poprzedni. Firma zastąpiła 1401 na 360 (model 30), a 7094 — na 360 (model 75). Model 75 był większy, pracował szybciej i kosztował drożej, ale programy napisane dla jednego z nich, mogli być wykorzystane w innym. W praktyce oprogramowanie napisane dla mniejszego modelu przeprowadzono dużą modelu bez większych trudności. Ale w przypadku przenoszenia oprogramowania z dużej maszyny na małą mogło zabraknąć pamięci. A jednak tworzenie takiej linii komputerów było dużym osiągnięciem. Pomysł stworzenia rodziny komputerów wkrótce stał się bardzo popularny, i w ciągu kilku lat większość firm komputerowych wydali serii podobnych komputerów o różnej wartości i funkcji. W tab. poniżej przedstawiono niektóre parametry z pierwszych modeli z rodziny 360. O innych modelach z tej rodziny powiemy dalej.

Pierwsze modele z serii IBM 360:

|

Parametry |

Model 30 |

Model 40 |

Model 50 |

Model 65 |

|

Względna wydajność |

1 |

3,5 |

10 |

21 |

|

Czas cyklu (ns) |

1000 |

625 |

500 |

250 |

|

Maksymalna wielkość pamięci (bajtów) |

65536 |

262144 |

262144 |

524288 |

|

Liczba bajtów, wywoływanych z pamięci za 1 cykl |

1 |

2 |

4 |

16 |

|

Maksymalna liczba kanałów danych |

3 |

3 |

4 |

6 |

Kolejną innowacją w 360 — wieloprogramowanie. W pamięci komputera mogło znajdować się jednocześnie kilku programów, i póki jeden program czekał, kiedy zakończy się proces wejścia - wyjścia, inna wykonywała się. W rezultacie, zasoby procesora wydatkowane były bardziej racjonalnie.

Komputer 360 był pierwszą maszyną, która mogła w pełni emulować pracę innych komputerów. Małe modele mieli możliwość emulować 1401, a duże — 7094, dlatego programiści mogli zostawić swoje stare programy bez zmian i wykorzystać je w pracy z 360. Niektóre modele 360 wykonywali programy napisane dla 1401 znacznie szybciej, niż sam 1401, dlatego stało bezsensowne modyfikacje programów.

Komputery z serii 360 mogli emulować pracę innych komputerów, ponieważ zostały stworzone z wykorzystaniem mikroprogramowania. Trzeba było pisać tylko trzy mikroprogramowania: jeden - dla systemu komend 360, drugiej - dla systemu komend w 1401, trzeci - dla systemu komend w 7094. Wymóg elastyczności stało się jedną z głównych przyczyn stosowania mikroprogramowania.

Na PC 360 udało się rozwiązać dylemat pomiędzy układów podwójnych i dziesiętnych wyliczeń: u tego komputera było 16 rejestrów po 32 bit dla arytmetyki binarnej, ale pamięć składała się z bajtów, jak w 1401. W 360 stosowane takie same polecenia, aby przenieść wpisy o różnej wielkości z jednego obszaru pamięci do drugiego, jak i w 1401.

Pojemność pamięci 360 wynosił 224 bajtów (16 MB). W tamtych czasach taka ilość pamięci wydawała się ogromną. Linia 360 później zmieniła się liniją 370, następnie 4300, 3080, 3090. U wszystkich tych komputerów była podobna architektura. W połowie lat 80-tych 16 MB pamięci było za mało, i IBM musiał częściowo odstąpić od zgodności, aby przejść do 32-bitowego adresowania, niezbędne dla pamięci o pojemności 232 bajtów.

Można by przypuszczać, że ponieważ maszyny były słowa do 32 bitów i rejestry, u nich mogli być i adresy w 32 bit. Ale w tym czasie nikt nie mógł sobie nawet wyobrazić komputer z pamięcią 16 MB. Obwinianie IBM ze względu na brak prognozowania jest oskarżać nowoczesnych producentów komputerów osobistych, że ich adresy są tylko 32 bity. Być może, za kilka lat ilość pamięci komputerów będzie wynosić znacznie więcej niż 4 GB, i wtedy adresów w 32 bit będzie za mało.

Świat mini-komputerów zrobił ogromny krok naprzód w trzecim pokoleniu wraz z produkcją linii komputerów PDP-11, zwolenników PDP-8 ze słowami na 16 bitów. W wielu związkach komputer PDP-11 był młodszym bratem 360, a PDP-1 — młodszym bratem 7094. I u 360 i u PDP-11 były rejestry, słowa, pamięć z bajtami, i w obu linijach komputery miały różną wartość i różne funkcje. PDP-1 był powszechnie stosowany, zwłaszcza w uniwersytetach, a firma DEC nadal prowadziła wśród producentów mini komputerów.

Czwarta generacja - wielkogabarytowe układy scalone (1980-?)

Pojawienie wielkogabarytowych układów scalonych (WGUS) w latach 80-tych pozwoliło stawiać na jedną kartę najpierw dziesiątki tysięcy, a następnie setki tysięcy, a w końcu miliony tranzystorów. To doprowadziło do powstania komputerów mniejszych i bardziej szybkich. Do momentu pojawienia PDP-1 komputery były tak duże i drogi, że firmy i uniwersytety musiały posiadać specjalne wydziały (centry liczące). Do 80 lat ceny spadły tak mocno, że możliwość zakupu komputerów pojawiła się nie tylko w organizacji, ale i u poszczególnych osób. Rozpoczęła się era komputerów osobistych.

Komputery osobiste były potrzebne do zupełnie innych celów niż ich poprzednicy. Były one wykorzystywane do przetwarzania tekstu, arkuszy kalkulacyjnych, a także do zastosowań z wysokim poziomem interaktywności (np. Gry), z którym duże komputery nie mogli sobie poradzić.

Pierwsze komputery osobiste były sprzedawane w zestawach. Każdy zestaw składał się z płytki drukowanej, zestawów układów scalonych, zwykle w tym obwodzie Intel 8080, pewną liczbę kabli, źródeł zasilania, a czasami dyskietek 8 cali. Złożyć z tych części komputer kupujący powinien był sam. Oprogramowanie do komputera nie było dołączono. Kupujący musiał napisać oprogramowanie sam. Później pojawił się system operacyjny CP/M, napisany przez Gary Kildella (Gary Kildall) dla Intel 8080. Ten działający system operacyjny mieścił się na dyskietce, zawierał on system zarządzania plikami i interpreter do wykonywania poleceń użytkownika, które rekrutowano z klawiatury.

Pierwsze komputery osobiste były sprzedawane w zestawach. Każdy zestaw składał się z płytki drukowanej, zestawów układów scalonych, zwykle w tym obwodzie Intel 8080, pewną liczbę kabli, źródeł zasilania, a czasami dyskietek 8 cali. Złożyć z tych części komputer kupujący powinien był sam. Oprogramowanie do komputera nie było dołączono. Kupujący musiał napisać oprogramowanie sam. Później pojawił się system operacyjny CP/M, napisany przez Gary Kildella (Gary Kildall) dla Intel 8080. Ten działający system operacyjny mieścił się na dyskietce, zawierał on system zarządzania plikami i interpreter do wykonywania poleceń użytkownika, które rekrutowano z klawiatury.

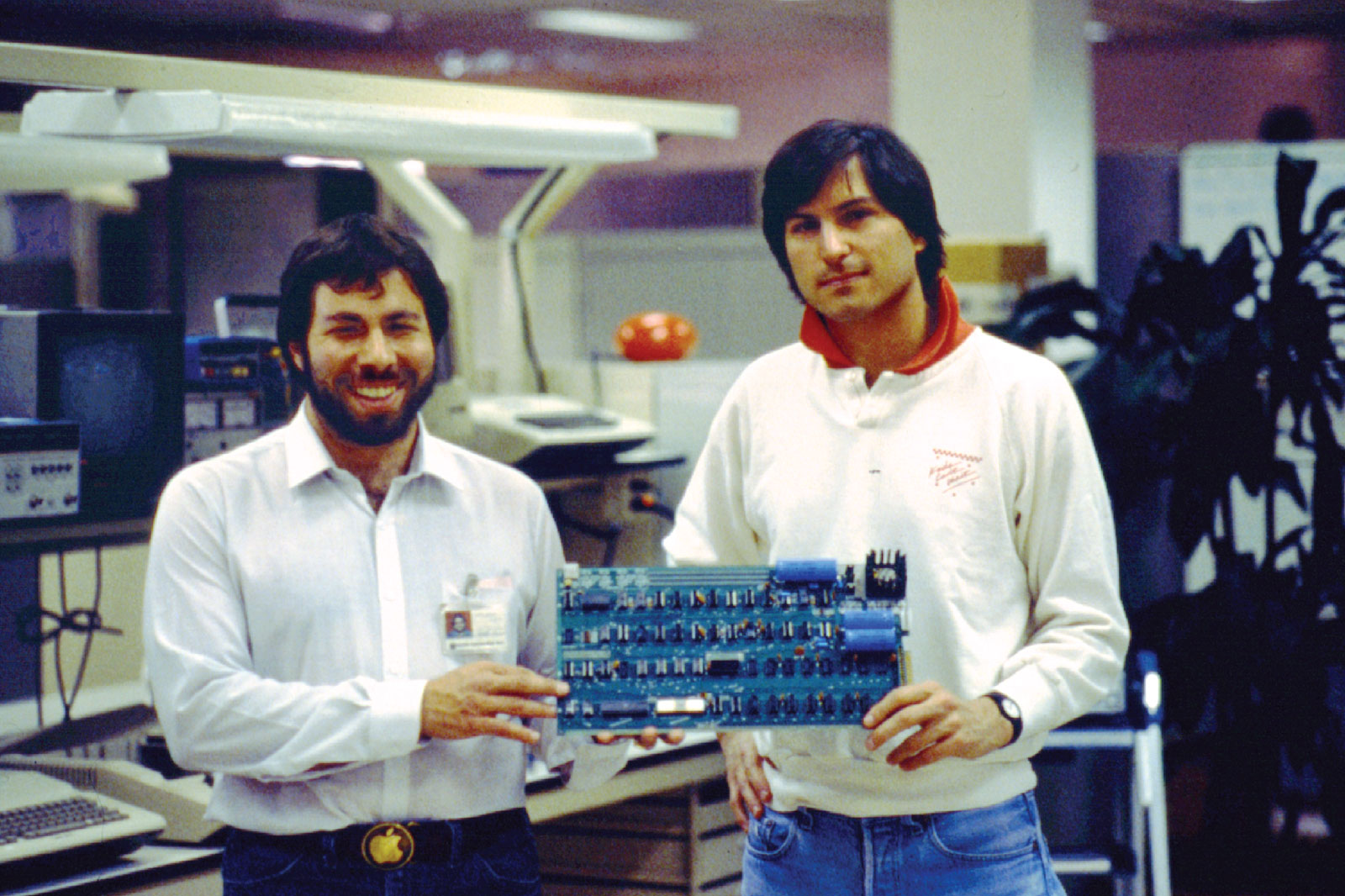

Jeszcze jeden komputer osobisty, Apple (a póżniej i Apple II), został zaprojektowany przez Stiwa Jobsa (Steve Jobs) i Stiwa Wozniaka (Steve Wozniak). Komputer ten stał się niezwykle popularny wśród użytkowników domowych i szkół, co w krótkim czasie uczyniło firmę Apple poważnym graczem na rynku.

Obserwując, co robią inne firmy, firma IBM, wiodąca wtedy na rynku komputerowym, też postanowiła zająć się produkcją komputerów osobistych. Ale zamiast tego, aby projektować komputer na podstawie poszczególnych komponentów IBM "od zera", co zajęło by to zbyt dużo czasu, firma przekazała jednemu ze swoich pracowników, Philipowi Estridżu (Philip Estridge), dużą sumę pieniędzy, i kazała mu udać się gdzieś z dala od biurokratów głównego zarządu spółki, znajdującego się w Armonku (szt. Nowym Jorku), i nie wracać, dopóki nie zostanie stworzony działający komputer osobisty. Estridż otworzył przedsiębiorstwo wystarczająco daleko od głównego zarządu spółki (w Florydzie), wziął Intel 8088 jako główny procesor i stworzył komputer osobisty z różnorodnych składników. Ten komputer (IBM PC) pojawił się w 1981 roku i stał najbardziej sprzedawanym komputerem w historii.

Jednak firma IBM zrobiła jedną rzecz, o której później żałowała. Zamiast utrzymywać projekt komputera w tajemnicy (lub co najmniej chronić się patentami), jak to zwykle robiła, firma opublikowała pełne projekty, w tym wszystkie schematy elektroniczne, w książce o wartości 49 dolarów. Książka ta została opublikowana po to, aby inne firmy mogli produkować wymienne karty dla IBM PC, co zwiększyłoby zgodność i popularność tego komputera. Niestety dla IBM, jak tylko projekt IBM PC stał się powszechnie znany, wiele firm zaczęło robić klony PC i często sprzedawali je znacznie taniej, niż IBM (ponieważ wszystkie części składowe komputera można było łatwo kupić). Tak rozpoczeła się szybka produkcja komputerów osobistych.

Chociaż niektóre firmy (takie jak Commodore, Apple oraz Atari) produkowali komputery osobiste z wykorzystaniem swoich procesorów, a nie procesoów Intel, potencjał produkcji IBM PC był tak wielki, że inne firmy ciężko wprowadzali się do rynku komputerów. Przeżyć udało się tylko niektórym z nich, i to tylko dlatego, że specjalizowały się w wąskich dziedzinach, na przykład, w produkcji stacji roboczych lub superkomputerów.

Pierwsza wersja IBM PC został wyposażony w system operacyjny MS-DOS, którą produkowała wtedy jeszcze malutka firma Microsoft. IBM i Microsoft wspólnie opracowali następującą za MS-DOS system operacyjny OS/2, w której charakterystyczną cechą był graficzny interfejs użytkownika (Graphical User Interface, GUI), podobny do interfejsu Apple Macintosh. Tymczasem firma Microsoft opracowała własny system operacyjny Windows, która pracowała na bazie MS-DOS, na wypadek, gdyby OS/2 nie miałby popytu. OS/2 naprawdę nie cieszył się popularnością, a Microsoft z powodzeniem kontynuował produkcję systemu operacyjnego Windows, co spowodowało ogromną niezgodę między IBM i Microsoft. Legenda o tym, jak małej firmie Intel i jeszcze bardziej małej, niż Intel, firmie Microsoft udało się obalić IBM, jedną z największych, najbogatszych i najbardziej wpływowych korporacji w historii świata, szczegółowo opowiada się w szkołach biznesu na całym świecie.

Początkowy sukces procesora 8088 inspirował firmę Intel na jego dalsze ulepszenia. Szczególnie na uwagę zasługuje wersja 386, wyprodukowana w 1985 roku, — jest to pierwszy przedstawiciel serii Pentium. Nowoczesne procesory Pentium znacznie szybciej procesora 386, ale z punktu widzenia architektury oni po prostu stanowią jego mocniejszą wersje.

W połowie lat 80-tych na zmianę CISC (Complex Instruction Set Computer — komputer z pełnym zestawem poleceń) nastąpił komputer RISC (Reduced Instruction Set Computer — komputer z skróconym zestawem poleceń). RISC- polecenia były łatwiejsze i pracowały znacznie szybciej. W latach 90-tych pojawiły się superskalarne procesory, które mogą wykonywać wiele poleceń jednocześnie, często nie w tej kolejności, w jakiej znajdowali się one w programie.

Aż do 1992 roku komputery osobiste były 8-, 16 - i 32-bitowymi. Następnie pojawił się rewolucyjny 64-bitowy model Alpha produkcji DEC — najbardziej, jak nie jest prawdziwy RISC-komputer, który znacznie przewyższał pod względem wydajności, wszystkie inne PC. Zresztą, wtedy sukces komercyjny tego modelu okazał się bardzo skromnym — tylko przez dziesięciolecie 64-bitowe komputery zyskały na popularności, i to tylko do profesjonalnych serwerów.

Piąta generacja — niewidzialne komputery (nasze dni)

W 1981 roku rząd Japonii poinformował o zamiarach przeznaczyć krajowym firmom 500 milionów dolarów na rozwój komputerów piątej generacji oparte na technologii sztucznej inteligencji, które miały przepędzić «napięte na głowę» PC czwartej generacji. Obserwując za tym, jak japońskie firmy szybko chwytają pozycji rynkowe w różnych dziedzinach przemysłu — od aparatów cyfrowych do systemów stereo i telewizorów, — amerykańscy i europejscy producenci w panice rzucili się do żądania od swoich rządów podobnych dotacji i innych pomocy. Jednak bez względu na ogromny hałas, japoński projekt rozwoju komputerów piątej generacji w końcu pokazał swoją bezsilność i był delikatnie «wsunięty do końca szuflady». W pewnym sensie ta sytuacja okazała się zbliżona do tej, z którą zderzył się Babbage: pomysł tak wyprzedzał swoje czasy, że do jego realizacji nie było odpowiedniej bazy technologicznej.

Jednak to, co można nazwać piąta generacja komputerów zmaterializowało się, ale w bardzo nieoczekiwanej postaci — komputery zaczęły szybko zmniejszać się. Model Apple Newton, który pojawił się w 1993 roku, dobitnie udowodnił, że komputer można zmieścić w obudowie o rozmiarach odtwarzacza kasetowego. Pismo ręczne, realizowane w Newton, wydawałoby się, skomplikował sprawę, ale później interfejs użytkownika podobnych urządzeń, które teraz nazywane „palmtopy” (Personal Digital Assistants, PDA), lub po prostu kieszonkowe komputery, został unowocześniony i zyskał szeroką popularność. Wiele komputerów przenośnych dziś nie są mniej wydajne, niż zwykłe PC wyprodukowane dwa-trzy lata temu.

Ale nawet mini PC nie były prawdziwym rewolucyjnym rozwojem. Znacznie większą wagę przykładają do tzw. "niewidzialnych" komputerów — te, którę wbudowane w sprzęt AGD, zegarki, karty bankowe i wiele innych urządzeń. Procesory tego typu zapewniają szerokie możliwości funkcjonalne i nie mniej szeroki wachlarz możliwości zastosowania za bardzo rozsądną cenę. Pytanie o to, czy można ograniczyć te układy scalone w jedno pełne pokolenie (a istnieją oni od 1970 roku), pozostaje kontrowersyjnym. Fakt, że one znacznie rozszerzają możliwości domowych i innych urządzeń. Już teraz wpływ niewidzialnych komputerów na rozwój światowej branży jest bardzo duży, a na przestrzeni lat będzie tylko rosnąć. Jedną z cech tego typu komputerów jest to, że ich sprzęt i oprogramowanie są często projektowane przez wspólny rozwój.

Sfinalizowanie

Więc, pierwsza generacja komputerów są uszeregowana na lampach próżniowych (takie jak ENIAC), do drugiej — tranzystorowe maszyny (IBM 7094), do trzeciej — pierwsze komputery na układach scalonych (IBM 360), do czwartej — komputery osobiste (linia Intel CPU). Co do piątej generacji, to ona już nie kojarzy się z konkretną architekturą, a ze zmianą paradygmatu.Komputery przyszłości będą mogły zostać wbudowane we wszystkie wyobrażalne i niewyobrażalne urządzenia i dzięki temu naprawdę staną się niewidoczne. Model, opracowany Markiem Wajzerem (Mark Weiser) w późniejszym okresie jego działalności, początkowo otrzymał nazwę powszechnej komputeryzacji, ale obecnie nie mniej rozpowszechniony termin «wszechobecna komputeryzacja». To zjawisko obiecuje zmienić świat, nie mniej radykalnie niż rewolucja przemysłowa!

Źródło: itandlife.ru

Musisz być zalogowany aby dodać komentarz.

kliknij tutaj zalogować się